METHOD FOR DETECTION OF HUMAN LIP MOVEMENTS IN THE VIDEO STREAM

Бирюков С. А.1, Розалиев В. Л.2, Орлова Ю. А.3

1Магистрант 2-го года обучения, 2Доцент, Кандидат технических наук, 3Доцент, Кандидат технических наук, Волгоградский государственный технический университет

МЕТОД ДЕТЕКТИРОВАНИЯ ДВИЖЕНИЯ ГУБ ЧЕЛОВЕКА В ВИДЕОПОТОКЕ

Аннотация

В современном мире все большую популярность набирают сервисы и системы для распознавания человеческой речи. Одним из вариантов получения машиной данных о речи является извлечение информации из видеопотока, поиск положения контрольных точек контура губ говорящего и анализ изменения положения точек. В статье представлен метод детектирования движений контура губ человека в видеопотоке с использованием камеры Microsoft Kinect. Описаны основные шаги метода и способ детектирования движений губ. Представленный метод позволяет эффективно распознавать простые движения губ человека в видеопотоке.

Ключевые слова: компьютерное зрение, распознавание лица, ключевые точки лица.Biryukov S. A.1, Rosaliev V. L.2, Orlova Y. A.3

1Graduate student of the 2nd year of study, 2Associate professor, PhD in Engineering, 3Associate professor, PhD in Engineering, Volgograd State Technical University

METHOD FOR DETECTION OF HUMAN LIP MOVEMENTS IN THE VIDEO STREAM

Abstract

In today's world, more services and systems of recognition of human speech are gaining more popularity. One option for obtaining data on the speech is to extract information from video, search positioning of the points of the lips and analyze changing of points position. The article presents a method for detecting human lip contour movement in the video stream using a Microsoft Kinect camera. The basic steps of the method and a method for detecting lip movements are described. The presented method can effectively recognize the simple human lip movements in the video stream.

Keywords: computer vision, facial recognition, the key point person.

Современные методы выделения нужной информации из видеопотока для распознавания речи недостаточно точны. На распознавание сильно влияет качество камеры, освещенность, угол наклона или поворота головы говорящего. Поэтому разработчики методов и инструментов в данной области стараются создать универсальные, устойчивые к изменению вышеперечисленных условий, алгоритмов и методов, позволяющих достаточно точно выделить губы из видеопотока и проанализировать их движения.

В качестве источника информации для распознавания движений губ может использоваться положение контрольных точек контура губ или лица в целом. В работах [1,2] представленные способы получения контрольных точек контура.

Некоторые исследователи не используют информацию о контрольных точках контура [3]. В качестве входной информации для анализа может служить прямоугольная область губ.

У каждого способа есть свои положительные и отрицательные стороны. В первом случае требуется провести больше вычислительных затрат на моменте поиска контура губ. Во втором случае требуется произвести больше вычислений для обработки области губ, для извлечения неких признаков, которые в последствии поддаются анализу.

В данной работе производится поиск точек контура губ на изображении и последующий анализ движения.

Данную задачу можно разделить на 2 крупных этапа. Первый этап – выделение точек контура на изображении. Второй этап – анализ положения точек и распознавание движения.

Распознавание точек контура губ.

Для решения проблемы выделения контура губ использовалась камера Microsoft Kinect. Она позволяет в режиме реального времени определять 121 ключевую точку лица человека, из которых 10 контрольных точек внешнего контура губ и 8 внутреннего. Камера специально создавалась для управления компьютерными играми, что говорит о высокой скорости работы камеры и предоставляемых библиотечных методах. [4,5]

Так же, использование камеры Kinect позволяет в задаче распознавания контура губ повысить точность распознавания, т.к. библиотечные методы используют для определения положения точек контура карту глубины и цветное изображение.

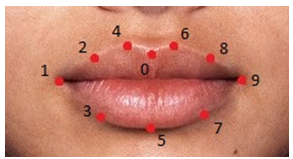

В результате распознавания, на данном этапе, определяются 10 точек внешнего контура губ. Нумерация точек контура в методе представлена на рисунке 1.

Рис. 1 – Нумерация точек в предложенном методе

Анализ положения точек.

Во время активности, человек не может статично держать голову, и поэтому координаты положения контрольных точек могу меняться даже если не производится никаких действий губами. Для решения этой проблемы можно дополнительно локализовать положение головы в кадре и производить вычисления изменения координат в пределах полученной области, но это приводит к дополнительным вычислительным ресурсам системы.

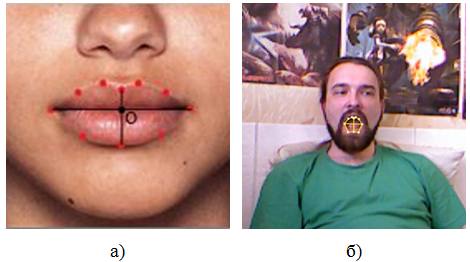

В данной работе для решения проблемы предлагается отказаться от статической системы координат. Если соединить ключевые точки уголков губ и среднюю верхнюю и нижнюю точки (точки 0-5 и 1-9, рис. 1), то получится новая система координат, начало координат которой перемещается вместе с остальными точками. Относительно данной системы можно однозначно сказать, как изменилось положение точки в пространстве. Схематический пример динамической системы координат представлен на рисунке 2а. Пример полученной системы представлен на рисунке 2б.

Рис. 2 – Динамическая система координат: а) схематический пример; б) результат

После вычисления положения начала координат требуется определить изменение положения точек. Вычисление координат точек контура в новой системе иногда сильно влияет на производительность метода, поэтому было решено использовать изменение длины отрезка, началом которого является точка начала координат новой системы, а концом – ключевая точка контура. Так же, в результате экспериментов было выявлено, что для определения движения не требуется вычислять значение изменения длины отрезка для верхних левой и правой точек (точки 4 и 6, рис. 1), т.к. однозначно можно утверждать изменение длины для центральной верхней точки. Вычисление производится один раз за каждый кадр, начиная со второго входного кадра видеопотока. После определения изменений формируется строка, в которой отражается изменение размера каждого отрезка. Для положительного изменения используется символ «+», для отрицательного – «-». Для исключения погрешности работы камеры, если изменение размеры меньше определенного значения – записывается «0». Получается строка из 8ми символов вида «+-+-+++-++», которая поддается дальнейшему анализу. Анализ движения.Анализ выглядит следующим образом. Существует заранее сформированный набор возможных действий. При получении информации об изменении размеров всех интересующих отрезков производится сравнение произошедшего действия с действием из списка. Для этого просто сравниваются отношения количества совпавших символов строки действия из набора и выходной строки к общему количеству символов строки. Во время вычисления сразу определяется максимальное значение отношения. Действие, которое имеет наибольший процент совпадений и будет наиболее вероятным произошедшим действием. Т.к. производится сравнение изменения положения точек между двумя кадрами, количество возможных действий сильно ограниченно. А именно это закрытие и открытие рта. Если рот открывается, то размер отрезков всех точек будет увеличиваться, и выходная строчка будет иметь наибольшее количество «+». Если рот закрывается, то в выходной строчке будут преобладать «-». Если же в данный момент не происходит никаких действий, или изменение размеров не велико, тогда либо губы находятся в статическом положении, либо производится последнее действие, но с достаточно медленной скоростью. То есть, если рот открывался, то при преобладании «0» в выходной строке, вероятно он либо открыт, либо все еще открывается.

Результаты.

В результате работы был получен эффективный метод, позволяющий определять простые действия губ в видеопотоке, получаемого с камеры Microsoft Kinect. Метод достаточно устойчив, в основном благодаря камере, к освещению и дополнительным помехам на лице (очки, борода или усы). Но процесс обнаружения лица при плохом освещении может занять большее время, чем при нормальном, дневном свете.

Скорость работы метода позволяет обрабатывать видеопоток в реальном времени. С камеры получается видеопоток с разрешением 640х480 пикселей и частотой 30 кадров в секунду. При этом, во время работы метода, не наблюдается прерывание потока.

Точность распознавания очень сильно зависит от двух критериев: точности обнаружения контрольных точек и точности определения изменения положения точек. Точность обнаружения контрольных точек достаточно хорошая. Особенностью работы библиотек Kineсt в том, что точки контура губ обнаруживаются относительно других контрольных точек головы.

Но основным недостатком метода является то, что производится определение только простых движения. Для определения более сложных действий, например – определения произносимых букв, требуется анализ большего количества кадров с использованием более сложных алгоритмов анализа.

Литература

- Самойлов Д. С. Биотехническая система распознавания фонем русской речи по изображению губ // Молодежный научно-технический вестник: электронный журнал URL: http://sntbul.bmstu.ru/doc/467494.html

- Ковшов Е. Е. Система обработки движения губ человека для речевого ввода информации / Е.Е. Ковшов, Т.А. Завистовская // Cloud of science. – 2014. – т. 1, №2. – С. 279 – 291.

- Zhao, G., Local Spatiotemporal Descriptors for Visual Recognition of Spoken Phrases / Z. Guoying, M. Pietikainen, A.Hadid // Proceedings of the international workshop on Human-centered multimedia. – 2007. – P. 57 – 66.

- Face Tracking [Электронный ресурс] – Режим доступа : https://msdn.microsoft.com/en-us/library/jj130970.aspx

- Kinect [Электронный ресурс] – 2016 – Режим доступа : https://en.wikipedia.org/wiki/Kinect

References

- Samojlov D. S. Biotehnicheskaja sistema raspoznavanija fonem russkoj rechi po izobrazheniju gub // Molodezhnyj nauchno-tehnicheskij vestnik: electronic journal URL: http://sntbul.bmstu.ru/doc/467494.html

- Kovshov E. E. Sistema obrabotki dvizhenija gub cheloveka dlja rechevogo vvoda informacii / E.E. Kovshov, T.A. Zavistovskaja // Cloud of science. – 2014. – v. 1, №2. – С. 279 – 291.

- Zhao, G., Local Spatiotemporal Descriptors for Visual Recognition of Spoken Phrases / Z. Guoying, M. Pietikainen, A.Hadid // Proceedings of the international workshop on Human-centered multimedia. – 2007. – P. 57 – 66.

- Face Tracking [Electronic resource] – Access mode: https://msdn.microsoft.com/en-us/library/jj130970.aspx

- Kinect [Electronic resource] – 2016 – Access mode: https://en.wikipedia.org/wiki/Kinect